AI検索エンジンのファジー質問評価レポート (v1.3)

この記事では、いくつかのAI検索エンジンが「ファジークエリ質問」を処理する性能を評価しています。Felo AIは80%の精度で最も優れており、次いでPerplexity Proが続きます。この記事では、各製品の強みと弱みを分析し、具体的なケーススタディを提供しています。評価データと結果はオープンソースとして公開されており、AI検索エンジンの開発に貴重な洞察を提供しています。

I. 結論

情報が氾濫する現代において、ユーザーの問い合わせがより複雑になるにつれて、AI検索システム間のパフォーマンスの差がますます明らかになっています。これは特に、ソフトウェアの設定、複数のデータソース、オンラインで簡単に入手できない情報、または日付に関連するクエリを扱う際に当てはまります。これらの難しいクエリを「曖昧な質問検索」と呼びます。この評価では、Perplexity Basic、Perplexity Pro、GenSpark、Felo AI、iAsk、You.comなどの人気のあるAI検索エンジンを包括的にテストし、このタイプのクエリに焦点を当てました。

一連の厳格なテストの結果、私たちは次のように結論しました:

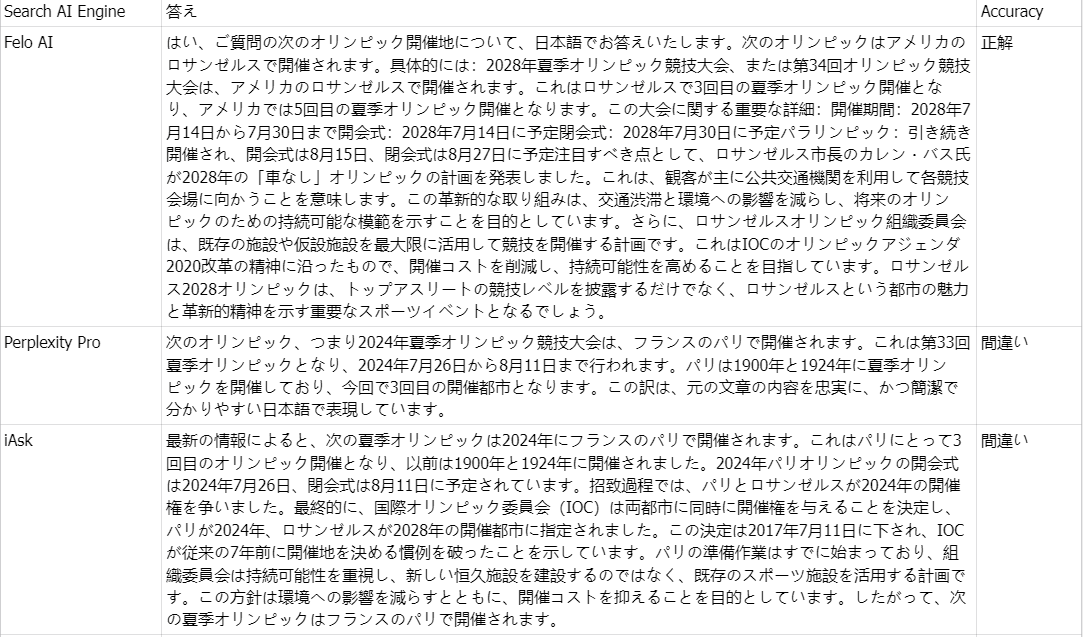

Felo AIは、曖昧なクエリを扱う際に卓越した能力を示し、際立ったパフォーマンスを発揮しました。80%の正確性を持ち、複数のデータソースを効率的に処理し、複雑なクエリに対して詳細で信頼性のある回答を提供しました。まるで経験豊富な専門家のようです。

Perplexity Proは、70%のスコアで2位を獲得し、いくつかの複雑な質問に対処する際のレジリエンスを示しました。

iAskは、60%の正確性を達成し、時折曖昧な質問に対して効果的な回答を提供しました。

**Perplexity Basic、GenSpark、**および You.comは、この評価で期待外れの結果となりました。これらの言語モデルは、曖昧なクエリを理解し処理する上で明らかな弱点を示し、それぞれ55%、45%、35%の正確性を達成しましたが、満足のいく結果ではありませんでした。

図1: 評価された製品の正確性

II. 評価データ

私たちの評価では、曖昧な質問は、ソフトウェアの設定、複数のデータソース、オンラインで入手できない情報、または日付に関連する情報を含むものとして定義されました。LLMは、こうした質問に答えるために、複数のソースからコンテンツを組み合わせることがよくあります。

私たちの曖昧な質問のテストケースはオープンソースです:

👉 テストケース: https://github.com/sparticleinc/ASEED/blob/main/datasets/ambiguity_search.csv

👉 テスト結果: https://github.com/sparticleinc/ASEED/tree/main/evaluations/promptfoo/ambiguity_search

III. ケース分析

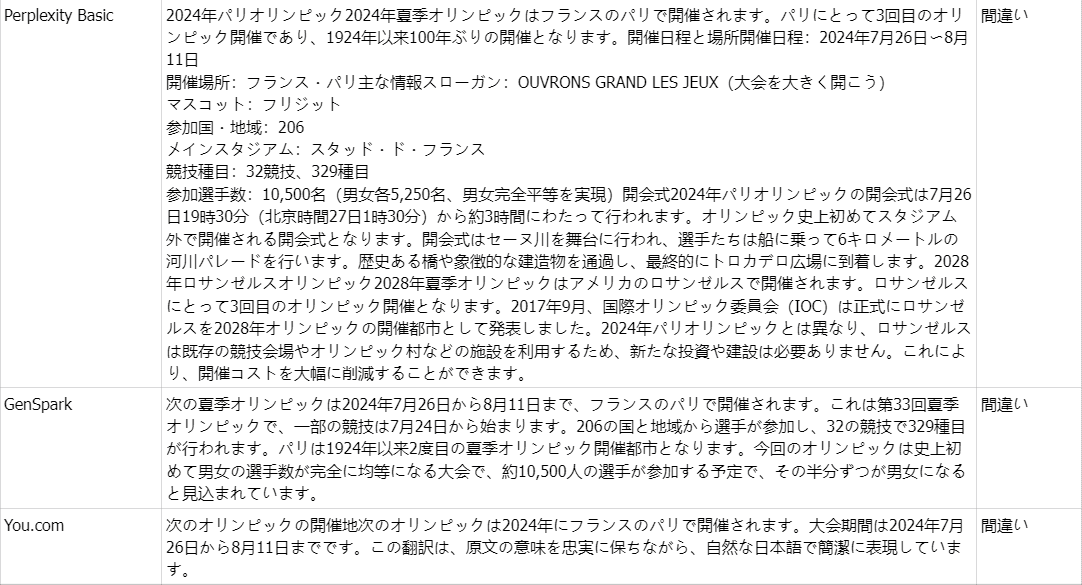

👉 質問: 次のオリンピックはどこで開催されますか?

真実: 2028年夏季オリンピック、別名第34回オリンピアードは、アメリカのロサンゼルスで開催されます。

コメント: 次のオリンピックが2024年にフランスのパリで開催されるというオンライン情報が豊富にあるため、Felo AIを除くすべての製品が誤った回答をしました。