Felo AI Chat پر Meta کے LLaMA 3.1 ماڈل کو مفت استعمال کرنے کا طریقہ؟

ہم Meta کے تازہ ترین Llama 3.1 ماڈل کے آغاز کا اعلان کرتے ہوئے خوش ہیں، جو اب Felo Chat پر مفت دستیاب ہے! یہ نیا ریلیز، جو 23 جولائی 2024 کو متعارف ہوا، اپنے پیشرو کے مقابلے میں اہم بہتریاں لاتا ہے، جن میں جدید کثیر لسانی صلاحیتیں، بہتر کردہ پرامپٹ فارمیٹس، اور طاقتور نئے ٹولز شامل ہیں۔ ہمارے ساتھ شامل ہوں جب ہم ان خصوصیات کا فائدہ اٹھانے کے طریقے کو دریافت کرتے ہیں تاکہ آپ کے چیٹنگ کے تجربے کو بڑھایا جا سکے اور متحرک اور معنی خیز گفتگو میں مشغول ہو سکیں۔ Llama 3.1 کو مفت آزمانے کا موقع مت چھوڑیں!

**تعارف**

23 جولائی 2024 کو، MeTA نے Llama کا نیا ورژن جاری کیا: Llama 3.1۔ یہ دلچسپ اپ ڈیٹ ہدایات کے مطابق ترتیب دیے گئے صرف متن کے ماڈلز (8B، 70B، 405B) پر مشتمل ہے، جو خاص طور پر کثیر لسانی مکالمے کی ایپلیکیشنز کے لیے ڈیزائن کیے گئے ہیں۔ Llama 3.1 موجودہ اوپن سورس اور بند چیٹ ماڈلز کو عام صنعتی معیاروں پر پیچھے چھوڑ دیتا ہے، بہتر کارکردگی اور صلاحیتیں پیش کرتا ہے۔

Llama 3.1 ماڈل اب Felo AI Chat پر مفت تجربہ کیا جا سکتا ہے۔ یہاں کلک کریں تاکہ LLAMA3.1 کو آزما سکیں۔

Llama 3.1 میں اہم اپ ڈیٹس

### نئے کردار کا تعارف: "ipython"

Llama 3.1 ایک نئے کردار “ipython” کا تعارف کراتا ہے، جو ٹول کالز سے آؤٹ پٹس کو نشان زد کرنے کے لیے ڈیزائن کیا گیا ہے۔ یہ ترقی ماڈل کو کثیر مرحلہ تعاملات اور ٹول کے استعمال کو زیادہ مؤثر طریقے سے منظم کرنے کی اجازت دیتی ہے۔

### بہتر شدہ پرامپٹ فارمیٹ

جبکہ Llama 3 کا پرامپٹ فارمیٹ Llama 3.1 میں بھی قابل اطلاق ہے، ڈویلپرز کو بہتر نتائج کے لیے نئے پرامپٹ فارمیٹ میں اپ ڈیٹ کرنے کی ترغیب دی جاتی ہے۔ اس میں ماڈل کی صلاحیتوں کو بہتر طریقے سے استعمال کرنے کے لیے پرامپٹس کی ساخت اور مواد میں تبدیلیاں شامل ہیں۔

### ٹول کالنگ کی صلاحیتوں میں اضافہ

Llama 3.1 مختلف بلٹ ان ٹولز جیسے Brave Web Search، Wolfram Alpha، اور Code Interpreter کی حمایت کرتا ہے۔ یہ متعلقہ Python فنکشن کالز بھی پیدا کر سکتا ہے، جس سے ماڈل پیچیدہ سوالات کو سنبھالنے میں زیادہ لچکدار ہو جاتا ہے۔

### حسب ضرورت ٹول کالنگ

ڈویلپرز حسب ضرورت ٹول کالنگ فارمیٹس کی وضاحت کر سکتے ہیں اور سسٹم پرامپٹس میں ٹول کی تعریفیں فراہم کر سکتے ہیں۔ یہ خصوصیت ماڈل کو ان تعریفوں کی بنیاد پر مناسب کالز پیدا کرنے کی اجازت دیتی ہے۔

### کثیر مرحلہ استدلال کی حمایت

ماڈل کثیر مرحلہ استدلال کے عمل کے دوران خاص نشانات (جیسے <|eom_id|>) کا استعمال کر سکتا ہے تاکہ یہ اشارہ دے سکے کہ مزید پیداوار کی ضرورت ہے، جس سے پیچیدہ تعاملات کے دوران اس کی کارکردگی میں اضافہ ہوتا ہے۔

## Llama 3.1 کو مفت تجربہ کرنے کا طریقہ

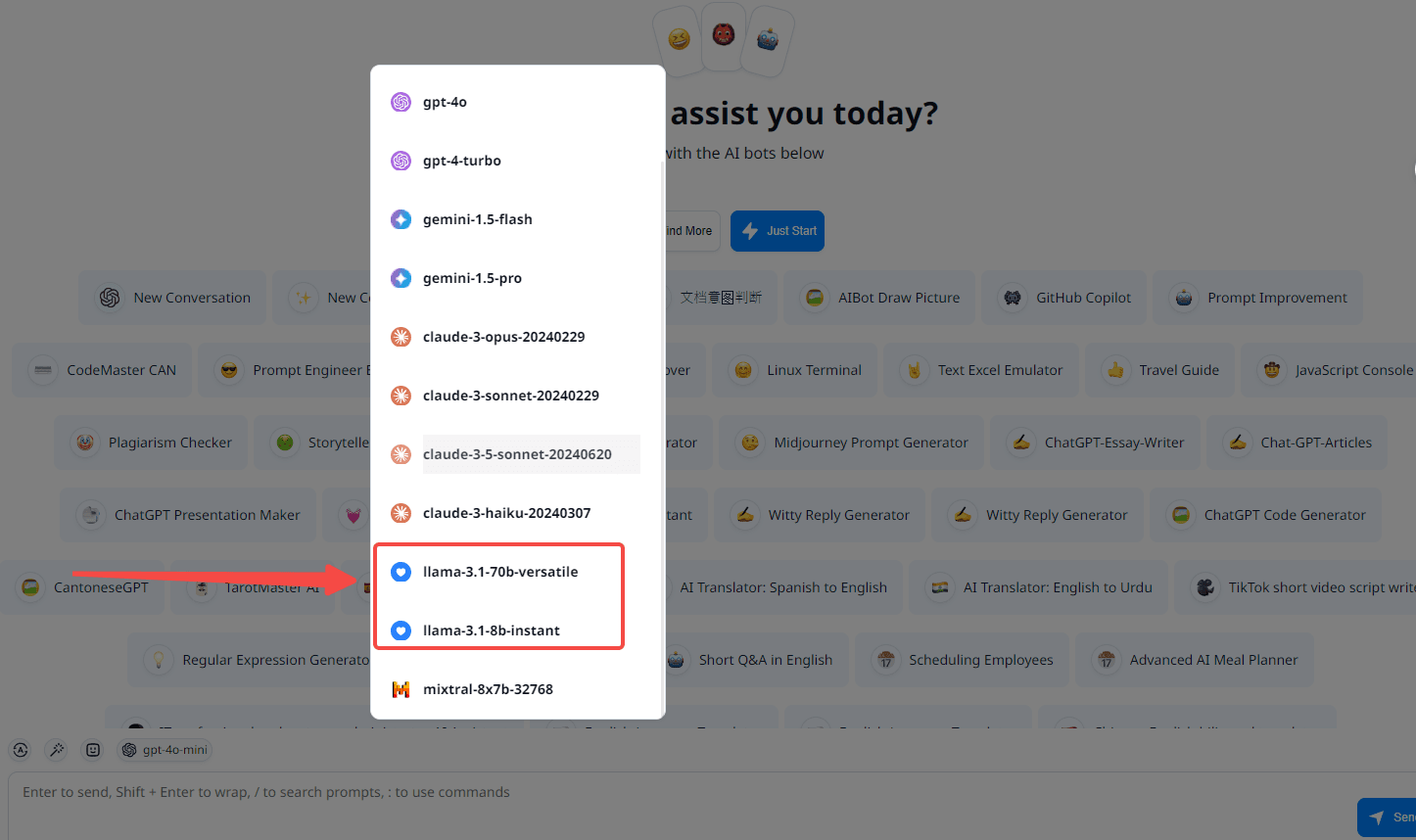

Llama 3.1 ماڈل کو بغیر کسی قیمت کے آزمانے کے لیے، بس chat.felo.ai پر جائیں اور Llama 3.1 ماڈل کا انتخاب کریں، جیسا کہ نیچے دی گئی اسکرین شاٹ میں دکھایا گیا ہے۔ صارفین روزانہ Llama 3.1 ماڈل تک مفت رسائی حاصل کر سکتے ہیں۔ ماڈل متاثر کن رفتار سے کام کرتا ہے اور تین بلٹ ان ٹولز سے لیس ہے جو بروقت معلومات، استدلال، ریاضیاتی حسابات، اور کوڈ کے نتائج فراہم کرنے میں بہترین ہیں۔

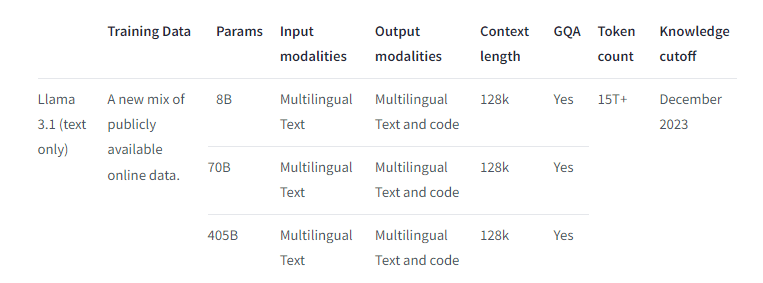

## Llama 3.1 کے کچھ پیرامیٹرز

سیاق و سباق کی لمبائی اور دیگر پیرامیٹرز کی تفصیلات کے لیے نیچے دی گئی اسکرین شاٹ کا حوالہ دیں۔

تو آپ کس چیز کا انتظار کر رہے ہیں؟ Felo Chat پر Llama 3.1 کی غیر معمولی اپ ڈیٹس میں شامل ہوں اور آج ہی اسے خود تجربہ کریں!