AI Search Engine 模糊问题评测报告 (v1.3)

本文评测了多款AI搜索引擎在处理"模糊问题查询"方面的表现。Felo AI以80%的准确率表现最佳,Perplexity Pro次之。文章分析了各产品的优劣势,并提供了具体案例说明。评测数据和结果已开源,为AI搜索引擎的发展提供了有价值的参考

一、结论

在现代信息爆炸的时代,随着用户问题复杂度的增加,AI Search系统的表现差异也愈加明显。尤其是当我们面对软件配置、多种数据源、网上找不到的信息、或者日期相关的问题时,AI的能力往往显得捉襟见肘。这类棘手的问题,我们暂称之为“模糊问题查询”。本次评测,我们针对这一类问题,全面测试了几款广受关注的AI Search引擎,包括Perplexity Basic、Perplexity Pro、GenSpark、Felo AI、iAsk和You.com。

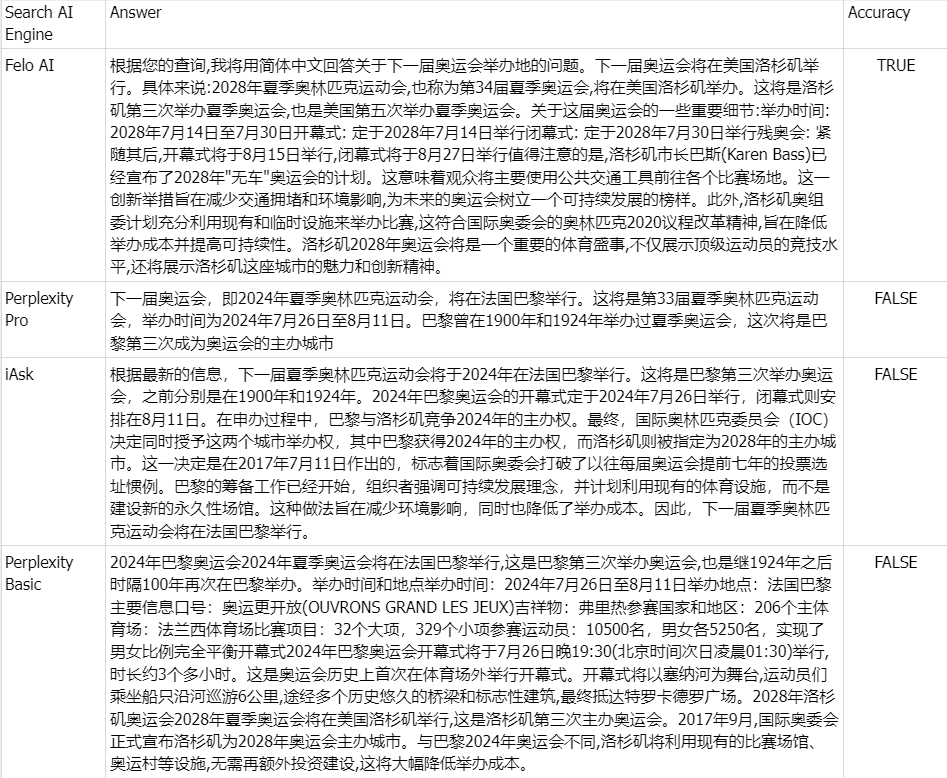

在一系列严格的测试后,我们得出了以下结论:

- Felo AI 是本次评测中的“佼佼者”,在处理模糊查询时展现出卓越的能力。它以惊人的**80%**准确率独占鳌头,不仅能够高效处理多源数据,还能在复杂查询中提供详实且可靠的答案,犹如一位经验丰富的专家。

- Perplexity Pro 则以70%的得分位居第二。它在应对某些复杂问题时仍表现得相当稳健。

- iAsk 没有特别出彩,以60%的正确率勉强及格,在面对模糊问题时有时能提供有效的答案。

- Perplexity Basic、GenSpark 和 You.com 则在这一轮的评测中显得相对乏力。它们的语言模型在理解和处理模糊查询上存在明显短板,分别取得了55%、45%和35%的正确率,表现不够理想。

图1 评测产品的准确率

二、评测数据

在我们的评测中,模糊问题被定义为涉及软件配置、多种数据源、网上不存在的信息、日期信息的问题。此类问题LLM经常把多个来源的内容进行拼凑回答。

我们的模糊问题测试用例已开源:

👉测试用例:https://github.com/sparticleinc/ASEED/blob/main/datasets/ambiguity_search.csv

👉测试结果:https://github.com/sparticleinc/ASEED/tree/main/evaluations/promptfoo/ambiguity_search

三、案例分析

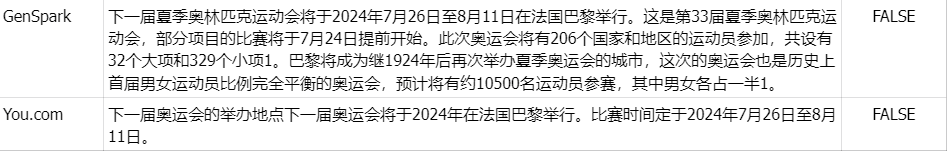

👉Question:下一届奥运会在哪里举行?

**Ground truth:**2028年夏季奥林匹克运动会,也称为第34届夏季奥运会,将在美国洛杉矶举办。

Comment: 由于网上大量信息都是下一届奥运会在2024年法国巴黎举办。除了Felo AI,其他产品均回答错误。